Las principales empresas de inteligencia artificial (IA), entre ellas OpenAI, Alphabet y Meta Platforms, se han comprometido voluntariamente con la Casa Blanca a aplicar medidas como una marca de agua en los contenidos generados por IA para contribuir a que la tecnología sea más segura, según informó el Gobierno de Biden.

Las empresas —entre las que también se encuentran Anthropic, Inflection, Amazon.com y Microsoft, socio de OpenAI— se comprometieron a probar a conciencia los sistemas antes de lanzarlos al mercado y a compartir información sobre cómo reducir los riesgos e invertir en ciberseguridad.

La medida se considera una victoria para los esfuerzos de la administración Biden por regular esta tecnología, que ha experimentado un auge de inversión y popularidad entre los consumidores.

También puede leer:

Senado de EE.UU. prohíbe las ventas de petróleo a China desde reservas estratégicas

Desde que la IA generativa, como ChatGPT, que utiliza datos para crear nuevos contenidos como prosa que escrita por personas, se hizo tremendamente popular este año, legisladores de todo el mundo empezaron a plantearse cómo mitigar los peligros de la tecnología emergente para la seguridad nacional y la economía.

En junio, Chuck Schumer, mayoritario en el Senado de Estados Unidos, pidió una «legislación exhaustiva» para avanzar y garantizar salvaguardias en materia de inteligencia artificial.

El Congreso está estudiando un proyecto de ley que obligaría a los anuncios políticos a revelar si se ha utilizado IA para crear imágenes u otros contenidos.

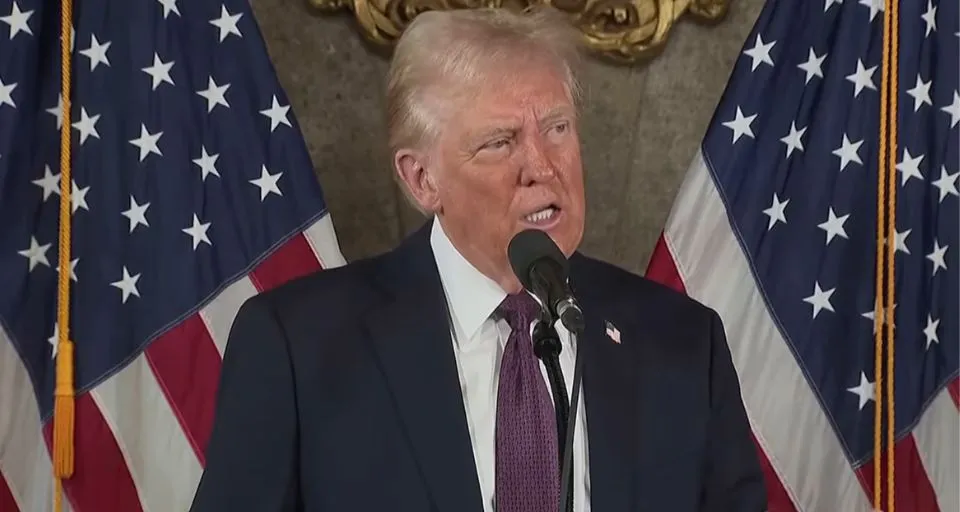

El presidente Joe Biden, que recibirá el viernes en la Casa Blanca a ejecutivos de las siete empresas, también está trabajando en la elaboración de una orden ejecutiva y una legislación bipartidista sobre la tecnología de IA.

Como parte del esfuerzo, las siete empresas se comprometieron a desarrollar un sistema de «marca de agua» en todas las formas de contenido, desde texto, imágenes, audios hasta vídeos generados por IA, para que los usuarios sepan cuándo se ha utilizado la tecnología.

Esta marca de agua, incrustada en el contenido de manera técnica, presumiblemente facilitará a los usuarios la detección de imágenes o audios falsificados que puedan, por ejemplo, mostrar violencia que no se ha producido, crear una estafa o distorsionar una foto de un político para poner a la persona bajo una luz poco favorecedora.

No está claro cómo se hará evidente la marca de agua al compartir la información.

Las empresas también se comprometieron a proteger la privacidad de los usuarios a medida que se desarrolle la IA y a garantizar que la tecnología esté libre de prejuicios y no se utilice para discriminar a grupos vulnerables. Otros compromisos incluyen el desarrollo de soluciones de IA para problemas científicos como la investigación médica y la mitigación del cambio climático.

Reuters